خطر نابودی انسان به دست هوش مصنوعی/ توسعه بیامان را متوقف کنید

به گزارش خبرگزاری علم و فناوری آنا به نقل از گاردین، یک دانشمند برجسته و فعال در زمینه هوش مصنوعی هشدار داده است که غولهای فناوری جهان مشهور به «بیگ تِک» در حال منحرف کردن افکار عمومی جهان هستند تا از خطر هوش مصنوعی برای بشریت غافل بمانند.

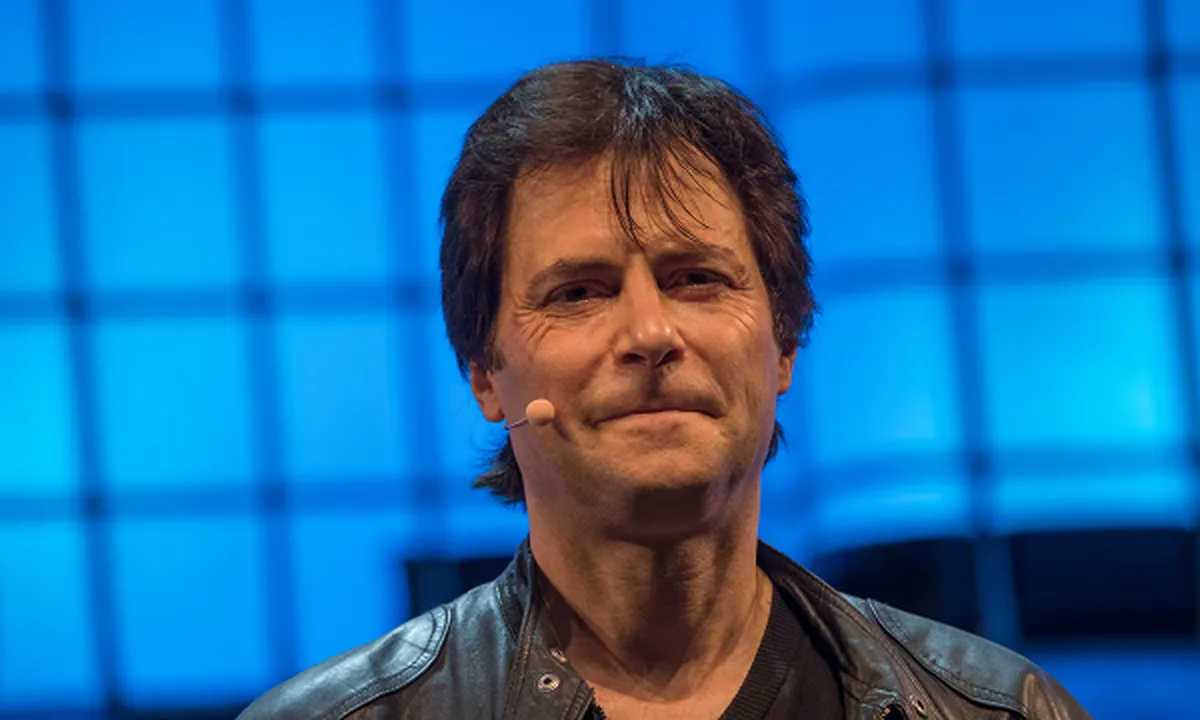

مَکس تِگمارک (Max Tegmark) استدلال میکند که کماهمیتسازی این خطر، تصادفی نیست. تهدید آن جدی است و تا خیلی دیر نشده، مقررات سختگیرانه و لازم باید به اجرا دربیایند.

این دانشمند و فیزیکدان سوئدی-آمریکایی در نشست اخیر هوش مصنوعی در سئول، کره جنوبی، گفت که گسترش تمرکز بر هوش مصنوعی باعث شده مقررات سختگیرانهای برای توسعهدهندگان قدرتمند هوش مصنوعی وضع نکنیم.

تگمارک گفت: انریکو فرمی (Enrico Fermi) در ۱۹۴۲، نخستین راکتور هستهایِ خودپایدار را در زیر یک زمین فوتبال در شیکاگو ساخت. وقتی فیزیکدانان برتر آن زمان از این موضوع خبردار شدند واقعاً ترسیدند، زیرا متوجه شدند که بزرگترین و تنها مانع باقیمانده برای ساخت بمب هستهای بهتازگی برطرف شده است. آنها فهمیدند که تنها چند سال با آن فاصله دارند که در واقع، سه سال بود، چرا که آزمایش هستهای ترینیتی در ۱۹۴۵ انجام شد.

موسسه غیرانتفاعی «فیوچر آو لایف» (Future of Life Tegmark) متعلق به تگمارک به دلیل نگرانی در مورد خطرات هوش مصنوعی برای بشریت، اخیراً خواستار توقف شش ماهه تحقیقات در حوزه هوش مصنوعی پیشرفته شد ولی با وجود حمایت بسیاری از کارشناسان، از جمله پیشگامان هوش مصنوعی مانند جفری هینتون و یوشوا بنجیو، این توقف اتفاق نیفتاد. درعوض، نشستهای هوش مصنوعی، مانند نشست سئول، بر تنظیم مقررات هوش مصنوعی متمرکز شدهاند.

تگمارک همچنین باور دارد که هوش مصنوعی در حال حاضر میتواند با آسیبهایی مانند سوگیری به حاشیه رانده شود. او معتقد است که رهبران فناوری از سوی صنایع مختلف تحت فشار هستند و به همین دلیل دولتها باید استانداردهای امنیتی برای توسعه مسئولانه هوش مصنوعی را توسعه دهند.

انتهای پیام/

- لوازم یدکی تویوتا قطعات تویوتا

- مشاوره حقوقی

- تبلیغات در گوگل

- بهترین کارگزاری بورس

- ثبت نام آمارکتس

- سایت رسمی خرید فالوور اینستاگرام همراه با تحویل سریع

- یخچال فریزر اسنوا

- گاوصندوق خانگی

- تاریخچه پلاک بیمه دات کام

- ملودی 98

- خرید سرور اختصاصی ایران

- بلیط قطار مشهد

- رزرو بلیط هواپیما

- ال بانک

- آهنگ جدید

- بهترین جراح بینی ترمیمی در تهران

- اهنگ جدید

- خرید قهوه

- اخبار بورس