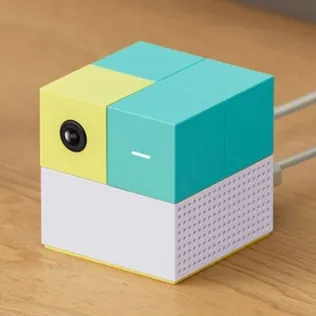

آیا هوش مصنوعی میتواند کشتارهای جمعی در مدارس آمریکا را پایان دهد؟

به گزارش گروه رسانههای دیگر خبرگزاری آنا، فایرستورم (Firestorm) یکی از شرکت هایی است که در زمینه مدیریت بحران عمل میکند. سوزی لافلین، مؤسس و مشاور ارشد این شرکت میگوید:

هدف ما این است که هیچ کودکی نخواهد با خودش اسلحه حمل کند و آن را به مدرسه بیاورد.

فایرستورم با همکاری مرکز آموزش تکمیلی دانشگاه آلاباما در آمریکا، برنامهای را آغاز کردهاند تا از بروز این رخدادهای فاجعه بار پیشگیری کنند. متخصصین در این برنامه به دنبال نشانههایی میگردند تا کودکان را در آستانهی رفتار خشونت بار آتی شناسایی نمایند.

این برنامه برتا (BERTHA) نام دارد که مخفف عبارت «برنامه سنجش تهدید خطرات رفتاری» است. ایده اولیه این پروژه در سال ۲۰۰۷ و پس از فاجعه دانشگاه ویرجینیا تک شکل گرفت. در این حادثه که یکی از مرگبارترین تیراندازیهای کور در تاریخ آمریکا محسوب میشود، ۳۲ نفر کشته شدند. تیراندازی دبیرستان استونمن داگلاس در شهر پارکلند ایالت فلوریدا در سال جاری میلادی که به کشته شدن ۱۷ نفر انجامید، موضوع پروژه را برجستهتر کرد و نهایتاً دو ماه قبل تیراندازی دبیرستان سانتا فه در تگزاس که ۱۰ نفر را به کام مرگ کشاند، ضرورت اجرای زودهنگام این پروژه را برای همگان به اثبات رساند.

جدول زیر تیراندازیهای مرگبار در مدارس آمریکا از سال ۱۹۸۸ به بعد را نشان میدهد:

برنامه ارزیابی ریسک به عنوان یک غربال امنیتی عمل میکند تا کودکان و نوجوانانی که به کمک و مداخلات خاص نیاز دارند را پیش از اقدام به خودکشی یا قتل، شناسایی نماید. پس از وقوع هر فاجعه مرگبار، تمام مسئولین، والدین و دانش آموزان افسوس میخورند که چرا به نشانهها و هشدارهای اولیه توجه نکردند، مواردی نظیر زورگویی در فضای مجازی، علاقه مفرط به اسلحه، یا اشاره به تیراندازی دبیرستان کلمباین در سال ۱۹۹۹. حالا شاید هوش مصنوعی بتواند این وظیفه را بر عهده بگیرد و جان دانش آموزان و دانشجویان را نجات دهد.

هوش مصنوعی در جستجوی نشانهها

چالش اصلی متخصصین، جستجو در میان انبوهی از دادهها در انجمنهای گفتگو یا شبکههای اجتماعی برای یافتن جزئیات خاص است تا بر اساس آنها بتوان رفتار غیر عادی کودکان را به مشاورین مدرسه یا روانشناسان اطلاع داد. برای غربال کردن اطلاعات خام در فضای آنلاین و نتیجه گیری از آنها، ابزارهای هوش مصنوعی میتوانند به کمک ما بیایند.

میلا لاکس، مؤسس و مدیرعامل شرکت میلو لاجیک (Meelo Logic) میگوید «ما بخش AI این پروژه هستیم». میلو لاجیک در پروژه برتا با فایرستورم همکاری میکند تا عملیات سنگین اولیه یعنی جستجو و مرتب سازی کلان داده را انجام دهد. تمرکز اصلی این شرکت روی تولید خودکار دانش و درک محتواست.

نرم افزار میلو میتواند با استفاده از فرایندی که به «استدلال سببی» معروف است، کامنتها و پستها را دنبال کند تا به منبع اولیه برسد. این روش شبیه یافتن «بیمار صفر» است، یعنی فردی که دیگران برای نخستین بار در موردش اظهار نگرانی کردهاند. هارت براون، مدیر عملیات فایرستورم میگوید: معمولاً طغیان اولیه به شکل آنلاین انجام میشود، و فرد به شکل آگاهانه چنین کاری را میکند تا به نوعی از دیگران کمک بگیرد. در ۸۰ درصد موارد، حداقل یک نفر دیگر هم از ماجرا آگاه است؛ بنابراین اگر پست اولیه به شکل خصوصی منتشر شود، باز هم میتوان بازتاب آن را در فرد دیگری یافت.

برنامه AI بر اساس واژگان و اصطلاحات معمول در شبکههای اجتماعی، مضمون گفتگو، موقعیت مکانی و پیوندهای مرتبط، میتواند غربالگری اولیه را انجام دهد. سپس متخصصین فایرستورم فعالیتهای مشکوک را برای مداخلات بیشتر جدا میکنند. اینجاست که مشاورین، معلمین و روانشناسان وارد صحنه میشوند تا تهدیدهای جدی و واقعی را شناسایی کنند. گاهی اوقات کودک به خاطر خشم یا تمایل به خودکشی به توجه و مشاوره نیاز دارد، و گاهی اوقات هم مسئله مهمی در بین نیست.

برندا ترولاو، یکی از مدیران این برنامه در دانشگاه آلاباما که با فایرستورم همکاری میکند، میگوید: هیچ شخص خاصی را نمیتوان تصمیم گیرنده نهایی دانست، چون هر فردی ممکن است برخی مسائل را نادیده بگیرد. اتخاذ تصمیم نهایی بر عهده یک تیم خواهد بود.

ترولاو به این نکته هم اشاره میکند که پروژه برتا بر اساس تجربیات معلمین، روانشناسان و دیگر متخصصین این حوزه پیش میرود تا قاعدهای نهایی برای مواجهه با بحرانهای احتمالی حاصل گردد.

افزایش امنیت یا نقض حریم خصوصی

پتانسیل هوش مصنوعی در پیشگیری از تیراندازیهای مرگبار آینده به خوبی قابل درک است، اما ردیابی و تجزیه و تحلیل اطلاعات در چنین سطحی، نگرانیهای زیادی را در مورد محرمانگی و حریم شخصی به وجود میآورد، ضمن اینکه احتمال تشخیص اشتباه و بروز مشکلات ناخواسته هم وجود دارد.

برایس آلبرت، دانش آموز پایه نهم دبیرستان استونمن داگلاس در زمان آغاز تیراندازی در طبقه سوم مدرسه حضور داشت. یکی از معلمین در فرصت مناسب توانست او را به داخل یکی از کلاسها بکشاند و همین اقدام، جان او را نجات داد. پس از این تجربه ناگوار، دیدگاه آلبرت در مورد محرمانگی و حریم شخصی به کل تغییر کرده و پایش شبکههای اجتماعی توسط مقامات را ضروری میداند.

لاکس (از شرکت میلو) بر این نکته تأیید میکند که برنامههای هوش مصنوعی به هیچگونه اکانت محرمانه دسترسی ندارند و فقط اطلاعات عمومی را ارزیابی میکنند. لافلین (از شرکت فایرستورم) هم میگوید آنها خودشان دادهها را جمع آوری یا ذخیره نخواهند کرد، بلکه افراد باتجربه در مدارس که به سوابق دانش آموزان دسترسی دارند، این مسئولیت را بر عهده میگیرند.

تشخیص ریزه کاریهای زبانی برای هوش مصنوعی دشوار است

به گفته لاکس، ریزه کاریها و ظرافتهای زبانی مانند طعنه و کنایه، میتواند تحقیقات AI را دشوار کند. برنامه میلو برخلاف پروژههای مشابه، روی آنالیز تصویری کار نمیکند و بیشتر به زمینه و مضمون محتوا توجه دارد. با این حال حتی از متخصصین زبده نیز احتمال اشتباه میرود، چه برسد به هوش مصنوعی. یکی از مشکلات این است که از طریق متن، به سختی میتوان احساسات و عواطف نویسنده را درک کرد. البته AI باید بتواند تا جای ممکن بیطرفانه عمل کند و تمامی تغییرات عاطفی و رفتاری که ممکن است منجر به بروز مشکل شوند را در نظر بگیرد.

براون (از شرکت فایرستورم) در این رابطه میگوید: نهایتاً سیستم باید بتواند سوگیری و تعصب را به طور کامل کنار بگذارد. یک متخصص نیروی انسانی یا مشاور ممکن است خشم ناگهانی افراد را نادیده بگیرد، با این توجیه که برای همه اتفاق میافتد. در مقابل، سیستم کامپیوتری هیچگاه چنین بهانههایی را نخواهد آورد.

با این حال برای ادامه راه به نیروی انسانی نیاز داریم تا با دانش آموزان و دانشجویان مصاحبه کند، چون کامپیوتر نمیتواند تشخیص دهد که باید این فرد را اخراج کرد یا مشکلش با مشاوره حل خواهد شد.

هوش مصنوعی؛ ابزار یا راه حل

تمامی متخصصینی که در این مقاله از آنها نام برده شده، بر این حقیقت تأکید میکنند که هوش مصنوعی در حال حاضر صرفاً یک فیلتر یا ابزار ابتدایی برای پیشگیری از تیراندازیهای کور در مدارس است. پروژه برتا کودکان در معرض خطر را شناسایی میکند، ولی نمیتواند به مربیان و مسئولان بگوید که چگونه و چه زمانی مداخله کنند، یا اینکه اصلاً نیازی به مداخله هست یا خیر.

مدارس همچنان به تیم حرفهای نیاز خواهند داشت، از مربیان آموزش دیده گرفته تا روانشناسان زبده، و این نیاز با وجود سیستمهای هوشمند هم برطرف نخواهد شد. لاکس میگوید طبق آمار موجود، هرگاه یک تیراندازی و کشتار جمعی در مدارس رخ دهد، احتمال وقوع حادثه مشابه نیز بالاتر میرود.

نهایتاً اینکه عامل انسانی هنوز هم نقش اساسی را ایفا میکند. آلبرت به عنوان بازمانده یکی از مرگبارترین حوادث تاریخ آمریکا میگوید با یکدیگر صحبت کنید و در صورت نیاز، کمک بگیرید. هیچگاه از درخواست برای کمک نترسید.

منبع: دیجیاتو

انتهای پیام/4001

انتهای پیام/