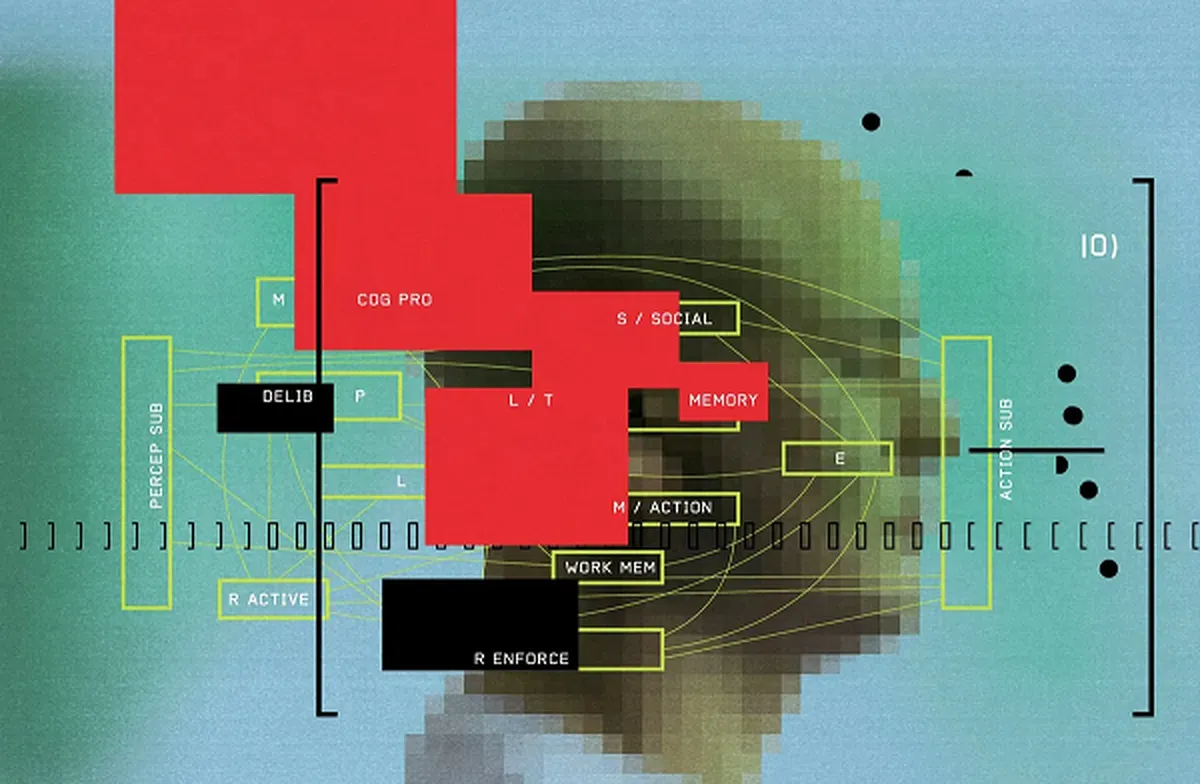

هوش مصنوعی به مرحله درک حالتهای ذهنی رسید

خبرگزاری علم و فناوری آنا؛ توانایی درک حالات روانی دیگران (نظریه ذهن) چیزی است که دنیای اجتماعی انسانها حول آن میچرخد. این توانایی به شما کمک میکند که تصمیم بگیرید در یک موقعیت پرتنش چه بگویید، حدس بزنید راننده ماشینهای دیگر ممکن است چه حرکتی انجام بدهند و یا حتی با یک شخصیت در فیلم یا سریال همدلی کنید.

طبق یک مطالعه جدید، مدلهای بزرگ زبانی که چت جیپیتی و مدلهای مشابه مبتنی بر آن کار میکنند، طبق یک مطالعه جدید، مدلهای بزرگ زبانی به مرحلهای رسیدهاند که میتوانند به طرز شگفتآوری این ویژگی ذاتی انسان را تقلید کنند.

عصر جدید ماشینهای ذهن

کریستینا بکیو (Cristina Becchio)، یکی از نویسندگان این مطالعه و استاد علوم اعصاب شناختی در مرکز پزشکی دانشگاه هامبورگ، میگوید: «قبل از اجرای مطالعه، همه ما متقاعد شده بودیم که مدلهای بزرگ زبانی از عهده چنین آزمونهایی برنمیآیند، بهویژه آزمونهایی که به تواناییهای ظریف برای سنجش حالات ذهنی میپردازند، اما با نتایج غیرمنتظره و شگفتانگیزی روبهرو شدیم.»

ما وارد عصر جدیدی از ماشینهایی شدهایم که مانند ما فکر میکنند. میخائیل کاسینسکی (Michal Kosinski) روانشناس از دانشگاه استنفورد میگوید که چندین مدل زبانی را روی تستهای رایج نظریه ذهن آزمایش کرده و دریافته است که بهترین این مدلها اُپنای آی-۴ است و ۷۵ درصد از وظایف خود را بهدرستی انجام داده و به گفته کاسینسکی با عملکرد یک کودک شش ساله مطابقت دارد.

با این حال، روشهای مطالعه کاسینسکی توسط محققان دیگر مورد انتقاد قرار گرفت چرا که آنها در آزمایشهای خود به این نتیجه رسیدند که مدلهای بزرگ زبانی اغلب به جای استدلال واقعی و مبتنی بر نظریه ذهن، بر اساس «روشهای اکتشافی سطحی» و با استفاده از راههای میانبرها، پاسخها را ارائه میدهند.

نویسندگان مطالعه حاضر به خوبی از این بحث آگاه بودهاند. جیمز استراکان (James Strachan)، یکی از نویسندگان این مطالعه، روانشناس شناختی در مرکز پزشکی دانشگاه هامبورگ میگوید: «هدف ما در این مقاله این بود که نظریه ماشین ذهن را به روشی نظاممندتر و با استفاده از وسعت آزمونهای روانشناختی به چالش بکشیم.» به گفته استراکان، در این آزمایش تواناییهای بیش از ۱۹۰۷ انسان با تواناییهای چندین مدل بزرگ زبانی محبوب، از جمله جیپیتی-۴ و لاما ۲ (Llama-۲) مقایسه شد.

«آزمایش نظریه ذهن» و به چالش کشیدن مدلهای زبانی

در این آزمایش مدلهای بزرگ زبانی و انسانها هر دو پنج نوع معمولی از وظایف تئوری ذهن را تکمیل کردند که سه مورد اول عبارت بودند از درک نکات، کنایه و گاف دادن. این مدلها در بخش چهارم به سؤالات مربوط به «باور نادرست» پاسخ دادند و در نهایت، پرسشهای نسبتاً پیچیدهای درباره «داستانهای عجیب» از آنها پرسیده شد که نشاندهندۀ دروغگویی افراد، دستکاری روانی یا سوءتفاهم بود.

برتریهای مدلها متفاوت بود

در مجموع، جیپیتی-۴ در صدر قرار گرفت و امتیازاتش با امتیازات انسان در آزمون باور غلط مطابقت داشت و در سه آزمون درک نکات، کنایه و داستانهای عجیب در مجموع نمراتی بالاتر از انسان گرفت. جالب اینجاست که امتیازات مدل لاما-۲ برعکس امتیازات جیپیتی-۴ بود و از نظر باورهای غلط با انسانها مطابقت داشت، اما عملکردش در مورد درک نکات، کنایه و داستانهای عجیب بدتر از انسان بود و البته در گاف ندادن عملکرد بهتری داشت.

مدلهای بزرگ زبانی، اغلب به جای استدلال واقعی بر اساس روشهای سطحی و راههای میانبر پاسخ میدهند.

برای فهمیدن اینکه در نتایج مربوط به گاف دادن چه اتفاقی میافتد، محققان مجموعهای از آزمونهای پیگیری را به مدلها دادند که چندین فرضیه را بررسی کرد. آنها به این نتیجه رسیدند که جیپیتی-۴ میتواند به سؤالی در مورد یک گاف فاحش، پاسخ صحیح بدهد، اما با برنامهنویسی «بیش از حد محافظهکارانه» در مورد اظهارات متعصبانه، دیگر نتوانست پاسخهای درست بدهد.

استراکان خاطرنشان میکند که اُپنای آی سپرهای امنیتی زیادی را در اطراف مدلهای خود قرار داده است که «برای حفظ مدل واقعی، صادقانه و در مسیر درست طراحی شدهاند» و معتقد است استراتژیهایی که برای جلوگیری از توهم جیپیتی-۴ (یعنی خیالبافی) در نظر گرفته شده نیز ممکن است مانعتراشی کنند.

چرا دستکاری متن مهم و نگرانکننده است؟

محققان سعی کردند از مشکلات روششناختی که انتقاداتی علیه مقاله کاسینسکی (۲۰۲۳) را برانگیخت، اجتناب کنند. به عنوان مثال آزمونها را در چند جلسه مختلف انجام دادند تا نتوانند پاسخهای صحیح را در طول آزمون یاد بگیرند و ساختار سؤالات را تغییر دادند، اما دو تن دیگر از محققان هوش مصنوعی که نقدی بر مقاله کاسینسکی نوشته بودند میگویند که نتایج این مطالعه آنها را قانع نکرده است. یوآ گلدبرگ (Yoav Goldberg)، محقق هوش مصنوعی و از منتقدان مقاله کاسینکی میگوید: مدلها انسان نیستند و هنگام مقایسه، ممکن استبهراحتی نتایج آنها را با نتایج انسانی اشتباه بگیریم.

امیلی بندر (Emily Bender)، استاد زبانشناسی محاسباتی در دانشگاه واشنگتن، به دلیل اصرارش بر سرکوب تبلیغات پرسروصدایی که هوش مصنوعی به راه انداخته، مشهور شده است. او با این سؤال پژوهشی که انگیزه پژوهشگران را برانگیخته است، مخالفت دارد:

«سیستمهای دستکاری متن میتوانند در مواجهه با سؤالات مشابهی که از انسانها پرسیده میشود، پاسخهایی مشابه بدهند. اما چرا این موضوع اهمیت دارد؟»

بندر میگوید: «مشخص نیست که داشتن یک مدل ذهنی برای مدلهای بزرگ زبانی چه معنایی دارد و بنابراین مشخص نیست که آیا این آزمایشها سنجیده و حسابشده هستند یا خیر.»

تبلیغات هوش مصنوعی، اغراقآمیز است و مقایسه این مدلها با انسان اشتباه است.

مدلهای هوش مصنوعی در تعامل با کاربران انسانی خود و پیشبینی نیازهای آنها عملکرد بهتری دارند، اما به همین نسبت میتوانند فریبکاری یا دستکاری را بهتر از کاربران انسانی یاد بگیرد و به کار ببندد. بِندر نگران محققانی است که تواناییهای شناختی انسانگونه را به سیستمهای هوش مصنوعی نسبت میدهند، مورد بحث قرار میدهد؛ و استدلال میکند مقایسه سیستمهای هوش مصنوعی با انسانها نامناسب است و در مورد تأثیرات منفی رفتار با هوش مصنوعی به گونهای که گویی افکار و نیات انسانمانند دارد هشدار میدهد. به نظر بندر بسیار مهم است که عواقب تقلید سیستمهای هوش مصنوعی از انسان را در نظر بگیریم، چرا که احتمال فریبکاری و دستکاری فکری را بالا میبرد و علاوه بر این، ممکن است مردم به اشتباه فکر کنند این سیستمها، ذهنی شبیه به انسان دارند.

این گزارش از پایگاه خبری اسپکتروم به فارسی ترجمه شده است.

انتهای پیام/

- غذای سازمانی

- خرید کارت پستال

- لوازم یدکی تویوتا قطعات تویوتا

- مشاوره حقوقی

- تبلیغات در گوگل

- بهترین کارگزاری بورس

- ثبت نام آمارکتس

- سایت رسمی خرید فالوور اینستاگرام همراه با تحویل سریع

- یخچال فریزر اسنوا

- گاوصندوق خانگی

- تاریخچه پلاک بیمه دات کام

- ملودی 98

- خرید سرور اختصاصی ایران

- بلیط قطار مشهد

- رزرو بلیط هواپیما

- ال بانک

- آهنگ جدید

- بهترین جراح بینی ترمیمی در تهران

- اهنگ جدید

- خرید قهوه

- اخبار بورس