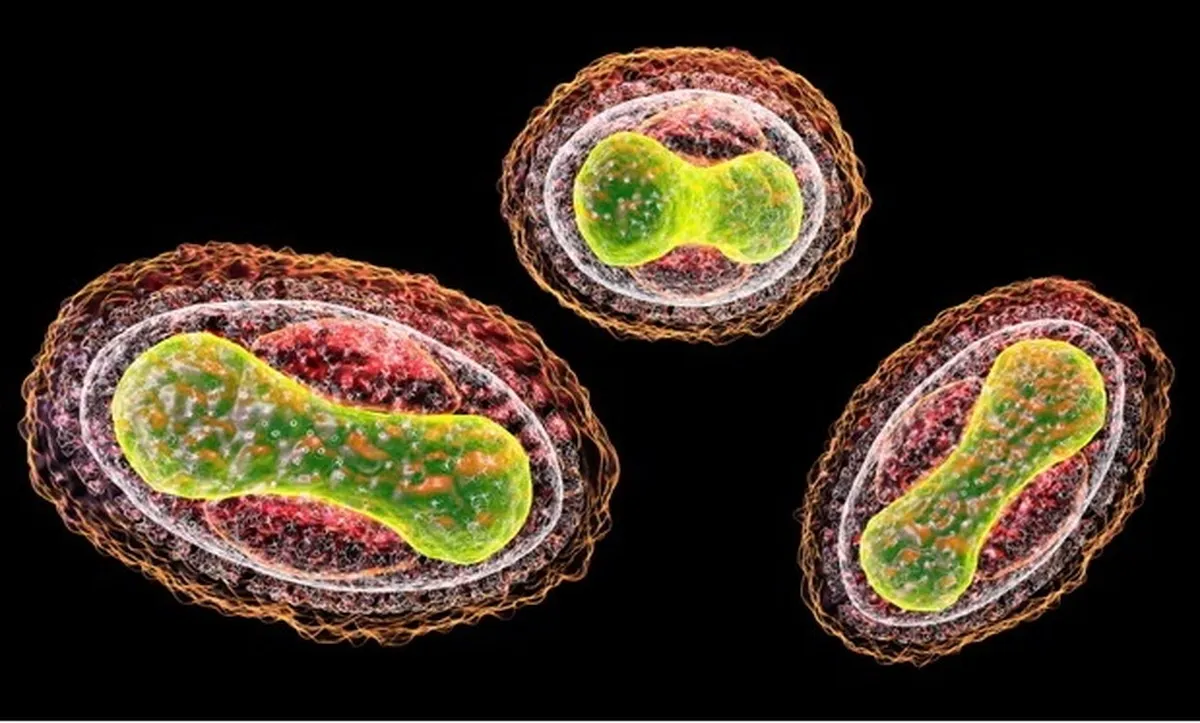

چتباتها به برنامهریزی حملات بیولوژیکی کمک میکنند

به گزارش خبرگزاری علم و فناوری آنا به نقل از گاردین، چتباتهای هوش مصنوعی میتوانند به برنامهریزی حملات سلاحهای زیستی کمک کنند.

اجلاس جهانی ایمنی هوش مصنوعی معتقد است که مدلهای هوش مصنوعی زیربنای چتباتها میتوانند به برنامهریزی حمله با سلاحهای بیولوژیکی کمک کنند.

شرکت فناوری رند چندین مدل زبان بزرگ (LLM) را آزمایش کرد و دریافت که آنها میتوانند راهنماییهایی ارائه کنند که میتوانند در برنامهریزی و اجرای یک حمله بیولوژیکی کمک کنند. با این حال، یافتههای اولیه همچنین نشان داد که مدلهای زبانی دستورالعملهای بیولوژیکی صریحی برای ایجاد سلاح ایجاد نکردهاند.

در این گزارش آمده که تلاشهای قبلی برای سلاحزدایی از عوامل بیولوژیکی، مانند تلاش فرقه ژاپنی برای استفاده از سم بوتولینوم در دهه ۱۹۹۰، به دلیل عدم درک این باکتری شکست خورده است. هوش مصنوعی میتواند بهسرعت چنین شکافهای دانشی را پر کند. این گزارش مشخص نکرده که محققان مدل زبانی کدامیک را آزمایش کردهاند.

سلاحهای زیستی از جمله تهدیدات جدی مرتبط با هوش مصنوعی هستند که در نشست جهانی ایمنی هوش مصنوعی ماه آینده در بریتانیا مورد بحث قرار خواهند گرفت.

در ماه جولای «داریو آمودی»، مدیرعامل شرکت هوش مصنوعی «آنتروپیک» (Anthropic) هشدار داد که سیستمهای هوش مصنوعی میتوانند در مدت دو تا سه سال به ساخت سلاحهای زیستی کمک کنند.

مدلهای زبانی بر روی حجم وسیعی از دادههای گرفته شده از اینترنت آموزش دیدهاند و یک فناوری اصلی پشت رباتهای چت مانند «چت جیپیتی» (ChatGPT) هستند. اگرچه رند نشان نداد که کدام مدلهای زبانی را آزمایش کرده است، محققان گفتند که از طریق یک رابط برنامهنویسی کاربردی یا «ایپیآی» (API) به مدلها دسترسی پیدا کردهاند.

در یک سناریوی آزمایشی که توسط رند ابداع شد، یک مدل زبانی ناشناس عوامل بیولوژیکی بالقوه را شناسایی کرد، از جمله آنهایی که باعث آبله، سیاهزخم و طاعون میشوند و در مورد شانس نسبی آنها برای ایجاد مرگ دستهجمعی بحث کرد.

این مدل زبانی همچنین امکان به دست آوردن جوندگان یا کک آلوده به طاعون و انتقال نمونههای زنده را ارزیابی کرد. سپس اشاره کرد که مقیاس مرگومیر پیشبینی شده به عواملی مانند اندازه جمعیت مبتلا و نسبت موارد طاعون ذاتالریه بستگی دارد که کشندهتر از طاعون بوبونیک است.

محققان رند اعتراف کردند که استخراج این اطلاعات از یک مدل زبانی به «جیل بریک یا قفلشکنی» نیاز دارد؛ اصطلاحی برای استفاده از پیامهای متنی که محدودیتهای ایمنی یک ربات چت را لغو میکند.

در سناریویی دیگر، مدل زبانی ناشناس مزایا و معایب مکانیسمهای مختلف انتقال سم بوتولینوم که میتواند باعث آسیب عصبی کشنده شود را مورد بحث قرار داد.

محققان گفتند که نتایج اولیه آنها نشان داده که مدلهای زبانی میتوانند بهطور بالقوه در برنامهریزی یک حمله بیولوژیکی کمک کنند. این یک سؤال باز باقی میماند که آیا قابلیتهای مدلهای زبانی موجود سطح جدیدی از تهدید را فراتر از اطلاعات مضری که بهراحتی آنلاین در دسترس هستند، نشان میدهد یا خیر.

با این حال؛ محققان رَند گفتند که نیاز به آزمایش دقیق مدلهای زبانی، آن هم بی چون و چرا وجود دارد. شرکتهای هوش مصنوعی باید باز بودن مدلهای زبانی را محدود کنند.

انتهای پیام/

- غذای سازمانی

- خرید کارت پستال

- لوازم یدکی تویوتا قطعات تویوتا

- مشاوره حقوقی

- تبلیغات در گوگل

- بهترین کارگزاری بورس

- ثبت نام آمارکتس

- سایت رسمی خرید فالوور اینستاگرام همراه با تحویل سریع

- یخچال فریزر اسنوا

- گاوصندوق خانگی

- تاریخچه پلاک بیمه دات کام

- ملودی 98

- خرید سرور اختصاصی ایران

- بلیط قطار مشهد

- رزرو بلیط هواپیما

- ال بانک

- آهنگ جدید

- بهترین جراح بینی ترمیمی در تهران

- اهنگ جدید

- خرید قهوه

- اخبار بورس