هفت سپر مقابل هفتتیر دیپ فیک/ محتوای جعلی علیه نامزدهای انتخابات را چطور شناسایی کنیم؟

خبرگزاری علم و فناوری آنا؛ دیپ فیکها، تصاویر و صداهای تولید شده جعلی از چهرههای مشهور سیاسی هستند که توسط هوش مصنوعی و برای گمراه کردن رأیدهندگان طراحی میشوند و تأثیر آنها بر نتایج و تصمیمگیریها نگرانی فزایندهای ایجاد کرده است. این نخستین بار است که دیپ فیک (جعل عمیق) یک عامل مهم و اثرگذار در انتخابات کشورهای سراسر دنیا خواهد بود.

اما عناصر بصری متعددی وجود دارند که با توجه به آنها میتوان محتواهای جعلی را از واقعی تشخیص داد.

در این مقاله با عناصر هشداردهندۀ دیپ فیک آشنا میشوید.

شکل عجیب و غریب دهان و چانه

در ویدیوهای دیپ فیک، ناحیه اطراف دهان میتواند بزرگترین راهنما باشد. ممکن است چین و چروکهای کمتری در پوست دیده شود، جزئیات کمتری در اطراف دهان وجود داشته باشد، یا چانه به شکلی نامنظم و لکهدار به نظر برسد. ناهماهنگ بودن صدا و حرکات دهان شخص در تصویر نیز میتواند نشان دیگری از دیپ فیک باشد.

ویدیوی دیپفیک زیر که در ۱۷ ژوئن منتشر شد، شبیهسازی نایجل فاراژ (Nigel Farage)، سیاستمدار بریتانیایی را نشان میدهد که خانه ریشی سوناک (Rishi Sunak) سیاستمدار بریتانیایی را در بازی ویدیویی ماینکرفت (Minecraft) تخریب میکند. این بخشی از روند ویدیوهای طنز عمیق جعلی است که در آن سیاستمدارانی در حال بازی آنلاین هستند.

چند روز بعد، ویدیوی شبیهسازی شده دیگری از کایر استارمر (Keir Starmer) سیاستمدار و رهبر حزب کارگر بریتانیا در حال بازی ماینکرفت منتشر شد.

دکتر مایری آیتکن (Mhairi Aitken)، کارشناس اخلاق در موسسه آلن تورینگ، موسسه ملی هوش مصنوعی بریتانیا، میگوید نخستین نکتهای که در دیپ فیکهای ماینکرفت جعلی بودن آن را فاش میکند «مضحک بودن وضعیت» است و نشانه دیگر ناهماهنگی بین صدا و دهان است.

آیتکن میگوید: این ناهماهنگی بهویژه در هنگام صحبت کردن فاراژ واضح است. یکی دیگر از نکات این است که آیا سایهها در جای درست قرار میگیرند؟ و یا خطوط و چروکهای صورت در زمان درست و مورد انتظار حرکت میکنند؟

اردی جانژوا (Ardi Janjeva) یکی دیگر از همکاران پژوهشی در مؤسسه آلن تورینگ میافزاید: وضوح پایین در سراسر ویدیو نشانه آشکار دیگری است که مردم باید متوجه آن شوند، زیرا شبیه چیزی است که تکه تکه به هم وصل شده است. البته به دلیل رواج ایمیلهای کلاهبردارانه بیشتر مردم با این رویکرد آماتور آشنا هستند. اگر مردم روی حرکات دهان و صورت تمرکز کنند به سادگی میتوانند تصاویر و ویدیوهای جعل عمیق را تشخیص دهند.

نشانههای غیرعادی در گفتار و جملهبندی

ویدیوی جعل عمیق (دیپ فیک) دیگری که از کایر استارمر در سال ۲۰۲۳ پخش شد او را در حال فروش یک طرح سرمایه گذاری نشان میداد که صداگذاری شده بود و در آدرس اینترنتی او در بخش پیام تبریک سال نو قرار گرفته بود.

اگر با دقت گوش کنید، متوجه خواهید شد که ساختار جمله عجیب و غریب است، به طوری که استارمر چندین بار قبل از تلفظ عدد، میگوید: «پوند»، برای مثال: «پوند ۳۵ هزار در ماه».

آیتکن میگوید در این ویدیو باز هم صدا و دهان با هم هماهنگ نیستند و قسمت پایین صورت تار است. او اضافه میکند که استفاده از کلمه «پوند» قبل از عدد نشان میدهد که برای بازسازی صدای استارمر احتمالاً از ابزار تبدیل متن به صوت استفاده شده است.

او میگوید: «سرنخهایی نیز در لحن وجود دارد. در ویدیوهای جعلی، یک ریتم و الگوی نسبتا یکنواخت حفظ میشود. برای بررسی صحت یک ویدیو، ایده خوبی است که صدا، رفتار و عبارات را با ویدیوهای واقعی فرد مقایسه کنید.»

هماهنگی بین صورت و بدن

در ویدیوی پایین این متن که با فناوری جعل عمیق (دیپ فیک) ساخته شده و در مارس ۲۰۲۲ پخش شد، رئیس جمهور اوکراین، ولادیمیر زلنسکی، از غیرنظامیان میخواهد سلاحهای خود را به خاطر ارتش روسیه زمین بگذارند. در این تصویر، اندازه سر با بقیه بدن تناسب ندارد و رنگ پوست صورت با گردن متفاوت است.

هانی فرید (Hany Farid)، استاد دانشگاه کالیفرنیا در برکلی و متخصص تشخیص دیپفیک، میگوید این یک «دیپفیک قدیمی است و اولین نشانهاش این است که بدن بیحرکت است.»

ناپیوستگی در سراسر کلیپ ویدیویی

این ویدئو که در ماه می ۲۰۲۴ منتشر شد، به دروغ متیو میلر (Matthew Miller)، سخنگوی وزارت امور خارجه آمریکا را نشان میدهد که در حال صحبت با یک خبرنگار است و حملات نظامی اوکراین به شهر بلگورود (Belgorod) روسیه را این گونه توجیه توجیه میکند که «عملاً هیچ فرد غیرنظامی در بلگورود باقی نمانده است». به گفته خبرنگار بی بی سی، این ویدیوی جعلی توسط سفارت روسیه در آفریقای جنوبی توییت شده و سپس حذف شده است.

در این ویدیوی جعلی کراوات و پیراهن سخنگوی وزارت خارجه آمریکا از یک نقطه از ویدیو به بعد تغییر رنگ میدهد. در حالی که این یک تغییر نسبتاً آشکار است، هانی فرید خاطرنشان میکند که چشمانداز هوش مصنوعی مولد به سرعت در حال تغییر است و بنابراین نشانگرهای جعل عمیق نیز تغییر میکنند، بنابراین باید مدام تمرین کنیم که اطلاعات دریافتی را با عقل سلیم بسنجیم و اندکی شک و تردید به خرج دهیم.

انگشتان، دستها و اندامهای اضافی

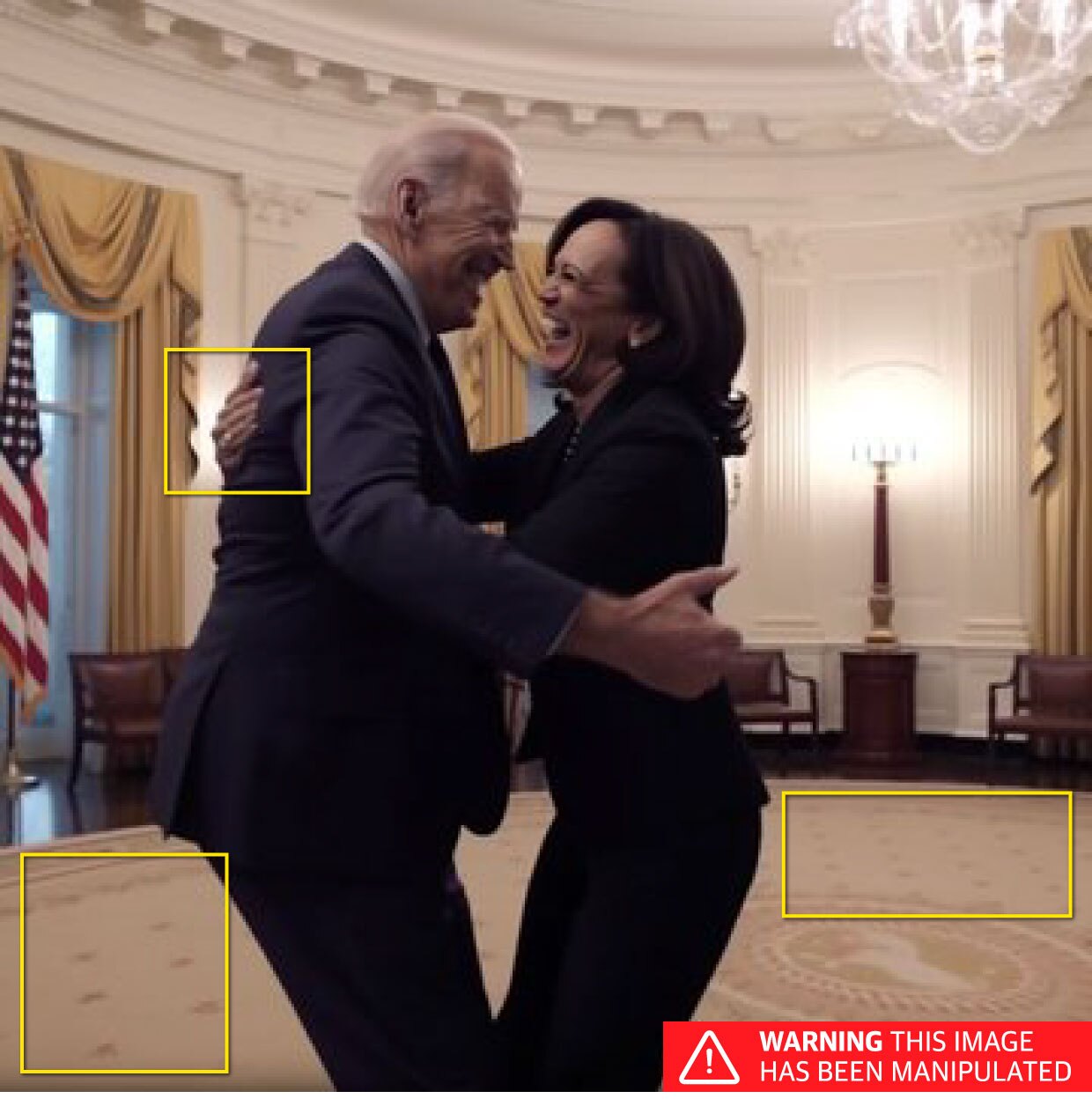

در تصاویر ثابتی که با هوش مصنوعی تولید میشوند، به تعداد انگشتان، پاها، بازوها و دستهایی که ظاهری عجیب دارند، توجه کنید. عکسی که ظاهراً جو بایدن و کاملا هریس (معاون او) را در حال جشن گرفتن کیفرخواست دونالد ترامپ نشان میدهد، در آوریل ۲۰۲۳ در توییتر منتشر شد.

نخستین نشانه مهمی که کمک میکند تا بفهمیم این عکس با هوش مصنوعی ایجاد شده دست راست کامالا هریس با شش انگشت است. بالای پرچم مخدوش است و الگوی روی زمین نیز انحراف دارد.

یک تیم هوش مصنوعی در شرکت ریلیتی دیفندر (Reality Defender) که در زمینه تشخیص دیپفیک فعالیت دارد، میگوید درخواستهایی که به ابزارهای هوش مصنوعی میدهیم اغلب میتوانند با تمرکز بر نام افراد شناختهشده و چهرههای مشهور تصویر تولید کنند، اما جعلی بودن این محتوا در جزئیات دیگری مانند دستها یا پسزمینههای تصویر و اشیای داخل آن آشکار میشود

تیم ریلیتی دیفندر توضیح میدهد: معمولاً درخواستهایی که برای ایجاد چنین تصاویری ارائه میشوند، با تأکید بر چهره افراد ساخته میشوند، بنابراین، خروجیها اغلب چهرههای انسانی معتبر با جزئیات زیاد تولید میکنند، ولی به رابطه فیزیکی و تناسب اجزا با یکدیگر (یا در بسیاری موارد، سایر قسمتهای بدن، مانند دستها) در پسزمینه توجهی ندارند.

تیم ریلیتی دیفندر که از ابزارهای تشخیص دیپ فیک استفاده میکند میگوید افزایش پیچیدگی برنامههای هوش مصنوعی دارد به مرحلهای میرسد که دیگر با بررسی ظاهری و دقت اولیه نمیتوان جعلی بودن محتوا را تشخیص داد.

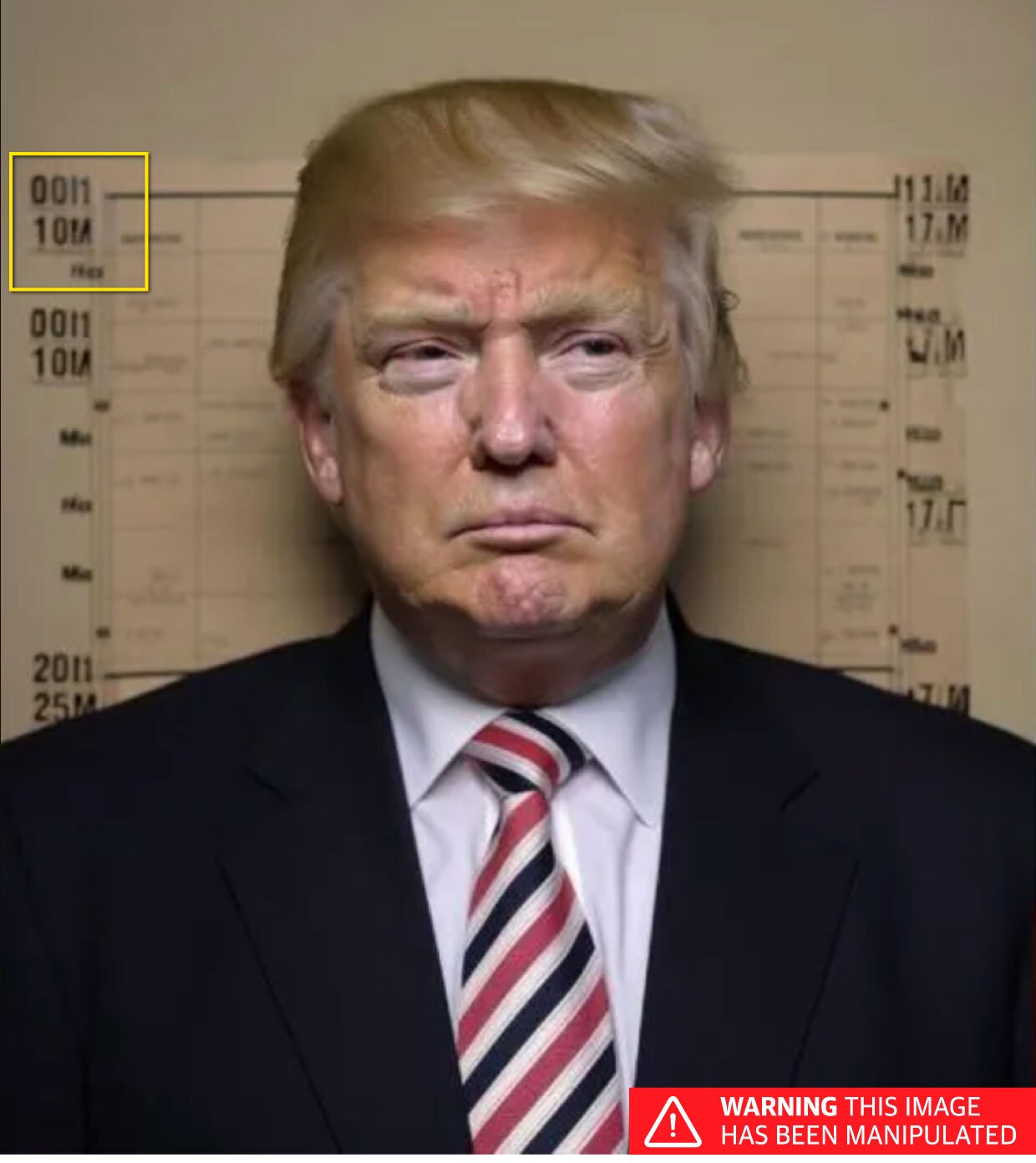

حروف و اعداد درهم ریخته

مولدهای تصویر هوش مصنوعی در بازآفرینی اعداد و متن مشکل دارند. عکس جعلی زیر از ترامپ که در آوریل ۲۰۲۳ منتشر شد با چنین ابزاری ساخته شده است. میتوانید ببینید که چگونه در پسزمینه، به جای نمودار عمودی، ترکیبی از اعداد و حروف بیمعنی وجود دارد.

آیتکن میگوید: اعداد و نوشتار در پسزمینه یک نشانه مهم هستند. مولدهای تصویر هوش مصنوعی واقعاً با تولید متن یا اعداد مشکل دارند. آنها از معنای نمادهایی که تولید میکنند درک درستی ندارند، بنابراین معمولاً متن و اعداد مخدوش یا ناخوانا تولید میکنند. بزرگنمایی تصویر و تمرکز بر متن یا اعداد موجود در تصویر راه تشخیص خوبی برای این است که آیا تصویر با هوش مصنوعی ساخته شده یا خیر.

ویرایشهای ناشیانه در ویدیوها

برخی از تصاویر دستکاریشده آنقدر آماتور کنار هم قرار میگیرند که به راحتی قابل تشخیص هستند. این دست تصاویر که به چیپ فیک (جعل بیارزش) شناخته میشوند، اغلب از نرم افزارهای ساده ویرایش ویدیو و سایر تکنیکهای دم دستی استفاده میکنند.

درست قبل از انتخابات مکزیک، ویدئویی از کلودیا شینبام (Claudia Sheinbaum)، نامزد وقت ریاست جمهوری، منتشر شد که میگفت: کلیساها را میبندد. این کلیپ به شیوهای عمداً گمراهکننده ویرایش شده بود چرا که شینبام در ویدیوی اصلی گفته بود: «آنها، به دروغ، میگویند ما کلیساها را میبندیم.»

در تلاش برای آسیب زدن بیشتر به این نامزد ریاست جمهوری، پسزمینهای جعلی نیز به ویدیو اضافه شد که نمادهای شیطانپرستی را نشان میداد.

این مقاله از مجله گاردین به فارسی ترجمه شده است.

انتهای پیام/