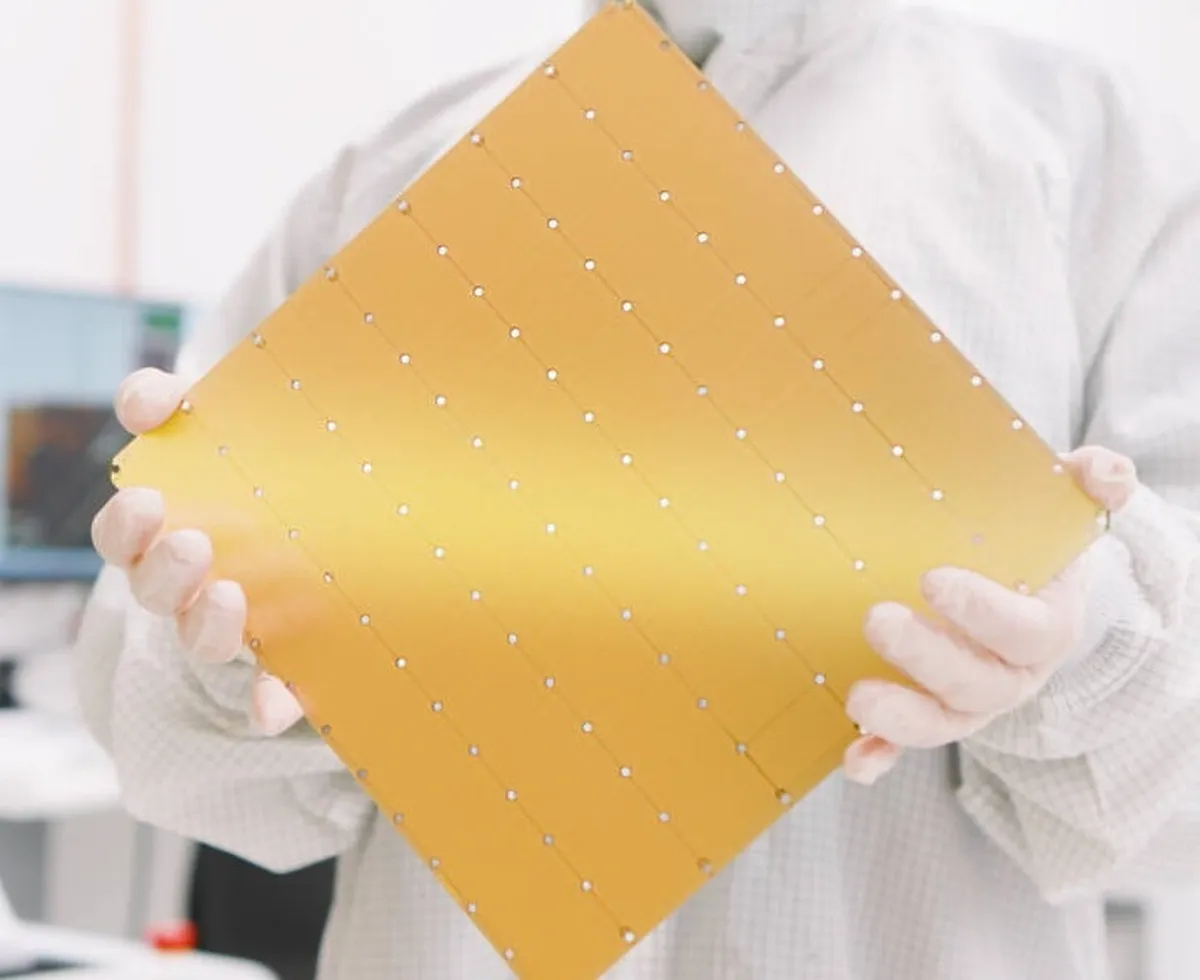

بزرگترین تراشه هوش مصنوعی جهان با ۴ تریلیون ترانزیستور رونمایی شد

به گزارش خبرگزاری علم و فناوری آنا به نقل از اینترستینگ اینجینرینگ، شرکت «سربراس سیستمز» (Cerebras Systems) مستقر در کالیفرنیا از «ویفر اسکیل انجین» (Wafer Scale Engine) یا بهاختصار (WSE-۳)، جدیدترین تراشه هوش مصنوعی خود با ۴ تریلیون ترانزیستور رونمایی کرد.

این تراشه دو برابر عملکرد قبلی خود یعنی سربراس «دبیلیو اسای-۲» (Cerebras WSE-۲) را ارائه میدهد که قبلاً رکورد سریعترین تراشه را در اختیار داشت. در بیانیه مطبوعاتی این شرکت آمده است که سیستمهای ساخته شده با استفاده از «دبیلیو اس ای-۳» قادر خواهند بود مدلها را با ۷۰ میلیارد پارامتر فقط در یک روز تنظیم کنند.

مدلهای هوش مصنوعی مانند جیپیتی با قابلیتهای بیشمار خود، دنیا را غرق کردهاند. با این حال، شرکتهای فناوری میدانند که مدلهای هوش مصنوعی هنوز در مراحل ابتدایی هستند و برای ایجاد اختلال در بازار نیاز به توسعه بیشتری دارند.

برای انجام این کار، مدلهای هوش مصنوعی باید روی مجموعه دادههای بزرگتری آموزش ببینند که به زیرساختهای بزرگتری نیاز دارند. انویدیا، سازنده تراشه، به لطف تقاضا برای تراشههای جدیدتر، بزرگتر و قدرتمندتر، به اوج خود رسیده است. تراشه H ۲۰۰ آن برای آموزش مدلهای هوش مصنوعی استفاده میشود و ۸۰ میلیارد ترانزیستور دارد. با این حال، سربراس «دبیلیو اسای-۳» قصد دارد عملکرد را تا ۵۷ برابر افزایش دهد.

نگاهی به مشخصات ابررایانه هوش مصنوعی سربراس

«دبیلیو اسای-۳» از معماری ۵ نانومتری استفاده میکند که برای ارائه ۹۰۰ هزار هسته بهینه شده و پردازش دادههای هوش مصنوعی در هنگام استفاده در «سیاس-۳» (CS-۳)، ابررایانه هوش مصنوعی این شرکت، طراحی شده است. این ابررایانه دارای یک حافظه ایستا (SRAM) روی تراشه ۴۴ گیگابایتی است. این میتواند ۲۴ تریلیون پارامتر را در یک فضای حافظه منطقی بدون طبقهبندی یا شکست آنها ذخیره کند. در بیانیه مطبوعاتی آمده است که این هدف برای ساده کردن چشمگیر گردش کار آموزشی و بهبود بهرهوری توسعهدهنده است.

حافظه خارجی ابررایانه «سیاس-۳» را میتوان از ۱.۵ ترابایت، بسته به نیاز مدل هوش مصنوعی در حال آموزش به ۱.۲ پتابایت افزایش داد. این کار برای آموزش مدلهایی ده برابر بزرگتر از جیپیتی-۴ یا جمنای انجام میشود. این شرکت ادعا میکند که آموزش مدل یک تریلیون پارامتری در «سیاس-۳» بهسادگی آموزش یک مدل یک میلیارد پارامتری بر روی پردازندههای گرافیکی است.

در صورت لزوم، «سیاس-۳» را میتوان برای نیازهای سازمانی یا مقیاس بزرگ ساخت. در یک پیکربندی چهار سیستمی، «سیاس-۳» میتواند مدلهای هوش مصنوعی متشکل از ۷۰ میلیارد پارامتر روزانه را به خوبی تنظیم کند. هنگامی که در پیکربندی سیستم ۲۰۴۸ راه اندازی شود، میتواند مدل ۷۰ میلیارد پارامتری لاما را در یک روز از ابتدا آموزش دهد.

بزرگترین تراشه هوش مصنوعی دنیا در کجا استفاده میشود؟

در زمانی که مصرف انرژی پردازندههای گرافیکی با هر نسل جدید دو برابر میشود، سربراس تضمین کرده است که آخرین تراشههایش بدون افزایش اندازه یا مصرف انرژی عملکردی دو برابری داشته باشند.

تراشه مخصوص هوش مصنوعی همچنین در مقایسه با پردازندههای گرافیکی به ۹۷ درصد کد کمتری برای آموزش مدلهای زبان بزرگ (LLM) نیاز دارد. به عنوان مثال، اجرای استاندارد یک مدل مانند جیپیتی-۳ تنها با ۵۶۵ خط کد به دست آمد.

سربراس قصد دارد «دبیلیو اسای-۲» را در تاسیسات همکاران قدیمی خود، آزمایشگاه ملی آرگون و کلینیک مایو، مستقر کند تا تواناییهای تحقیقاتی این موسسات را افزایش دهد.

انتهای پیام/

- لوازم یدکی تویوتا قطعات تویوتا

- مشاوره حقوقی

- تبلیغات در گوگل

- بهترین کارگزاری بورس

- ثبت نام آمارکتس

- سایت رسمی خرید فالوور اینستاگرام همراه با تحویل سریع

- یخچال فریزر اسنوا

- گاوصندوق خانگی

- تاریخچه پلاک بیمه دات کام

- ملودی 98

- خرید سرور اختصاصی ایران

- بلیط قطار مشهد

- رزرو بلیط هواپیما

- ال بانک

- آهنگ جدید

- بهترین جراح بینی ترمیمی در تهران

- اهنگ جدید

- خرید قهوه

- اخبار بورس