معرفی فناوریهای جذاب کاربردی در ۲۰۲۴/ از مهندسی پروتئین تا تشخیص جعل عمیق در رسانهها

به گزارش خبرنگار خبرگزاری علم و فناوری آنا، همواره استفاده از فناوری در عرصه های مختلف دچار تغییر تحولاتی می شود. مهندسی پروتئین، چاپ سه بعدی، تشخیص جعل عمیق در رسانهها و ... جزء زمینه هایی هستند که از فناوری بهره مند می شوند.

در این گزارش سعی داریم هفت حوزۀ فناوریهای پیشرفته را که به نقل از نیچر در آیندۀ نزدیک اهمیت فراوانی دارند، معرفی کنیم. ویژگی مشترک همۀ این فناوریها هوش مصنوعی و یادگیری عمیق است، اما بر خلاف رباتهای گفتوگوی هوش مصنوعی، این فناوریها چندان پر سروصدا نبودهاند. این هم دلیل دیگری است که سال جاری توجه بیشتری به این فناوریها داشته باشیم.

یادگیری عمیق برای طراحی پروتئین

دو دهه پیش، دیوید بیکر (David Baker) از دانشگاه واشنگتن در سیاتل و همکارانش به یافتهای مهم دست یافتند: آنها از ابزارهای رایانشی برای طراحی یک پروتئین کاملاً جدید استفاده کردند. بیتردید این یافته ارزش رسیدن به مقام هفت فناوری برتر را دارد، اما پروتئین ساخته شدۀ آزمایش آنها هیچ کارکرد زیستشناختی معاناداری نداشت.

امروزه طراحی پروتئین جدید به ابزاری عملی برای تولید آنزیمهای خاص و پروتئینها مختلف تبدیل شده است. نیل کینگ (Neil King)، بیوشیمیدان دانشگاه واشنگتن که با تیم بیکر برای طراحی واکسن و انتقال دارو با کمک پروتئینها همکاری میکند، میگوید: «این فناوری قدرت زیادی به ما میدهد. حدود یک سال و نیم پیش هیچ یک از این کارها ممکن نبودند، اما حالا خیلی راحت میتوانیم انجامشان دهیم.»

بخش اعظم این پیشرفت به خاطر مجموعۀ کلان دادههای فزایندهای است که امکان مرتبط کردن توالی پروتئین به ساختار آنها را فراهم میکند. اما روشهای پیچیدۀ یادگیری عمیق نیز در این پیشرفتها نقشی کلیدی داشتهاند.

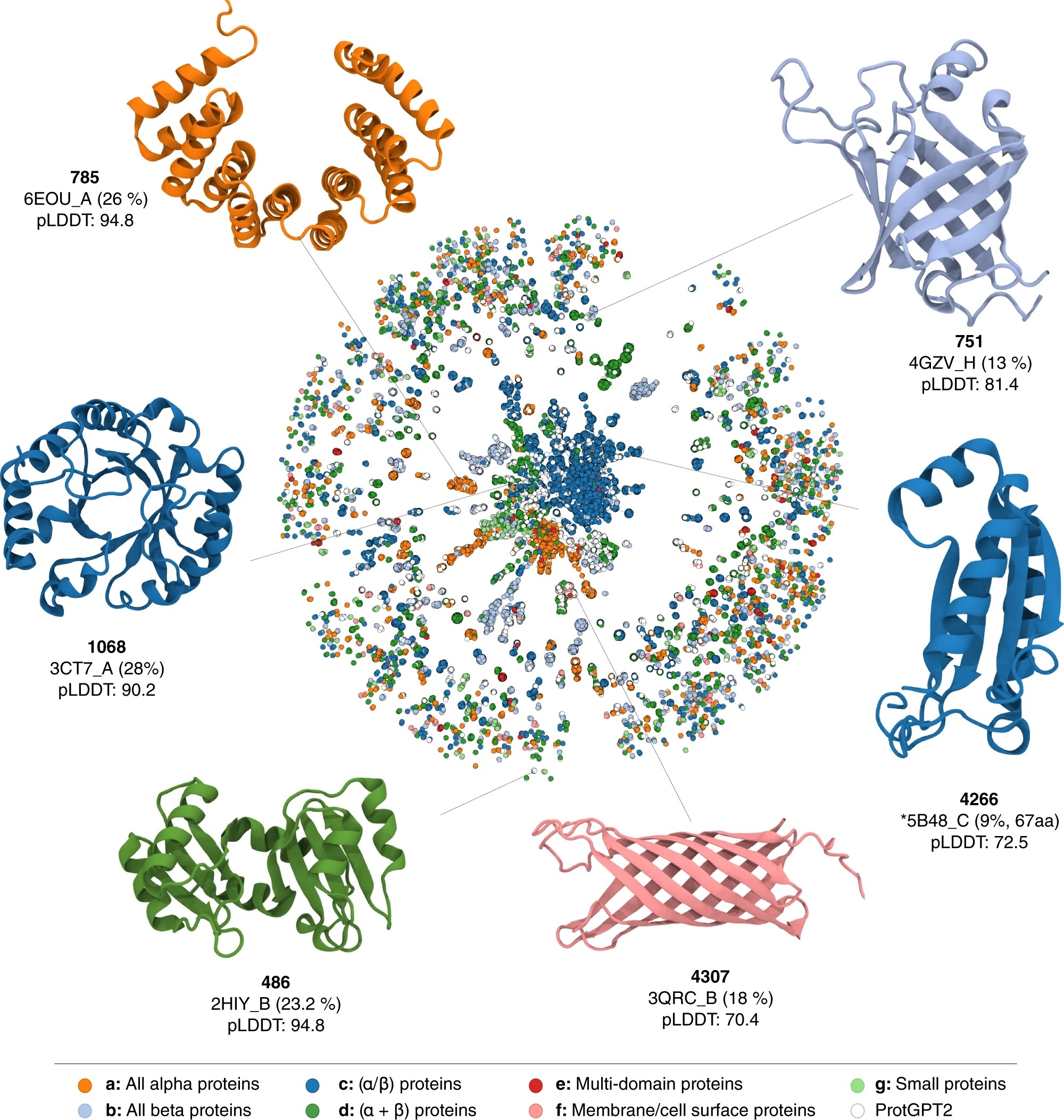

استراتژیهای «مبتنی بر توالی» از مدلهای زبانی بزرگ (LLM) استفاده میکنند. این مدلهای زبانی همان ابزار قدرتمندی است که در رباتهای گفتگو مثلاً ربات چت چتجیپیتی استفاده میشود (نگاه کنید به انتهای همین قسمت و بخش «چتجیپیتی؟ شاید سال بعد»). الگوریتمها مدلهای زبانی بزرنگ توالی پروتئینی را مثل اسنادی میبیند که به جای «کلمات» از پلیپپتید (polypeptide) تشکیل شدهاند. بدین ترتیب الگوریتم میتواند الگوهایی را تشخیص دهد که زیربنای معماری پروتئینهای دنیای واقعی هستند.

نولیا فروز (Noelia Ferruz)، متخصص بیوشیمی پروتئینی در موسسه زیستشناسی مولکولی بارسلونای اسپانیا، میگوید: «این الگوریتمها واقعاً این دستور زبان مخفی را یاد میگیرند.» در سال 2022، تیم نولیا الگوریتمی به نام پروتجیپیتی2 (ProtGPT2) توسعه داد که به طور مداوم طرحهایی برای پروتئینهای مصنوعی ارائه میداد، با این ویژگی خاص که پروتئینهای پیشنهادی پروتجیپیتی2 امکان تولید پایدار در آزمایشگاه را دارند. ابزار دیگری که نولیا توسعه داده است زیمکنترل (ZymCTRL) نام دارد که از دادههای توالی و عملکردی استفاده میکند تا با کمک آنزیمهای همخانواده، آنزیمهای طبیعی جدید تولید کند.

رویکردهای «مبتنی بر توالی» میتوانند برای ساختن چارچوبهای تازه، ویژگیهای پروتئینهای موجود را مبنا قرار دهند و با آنها انطباق پیدا کنند، اما برای طراحی عناصر ساختاری یا ویژگیهای از پیش تعیین شده چندان کارآمد نیستند، مثلاً این قابلیت را ندارند که آنزیمی تولید کنند که اهداف خاصی را دنبال کند.

اما رویکردهای «مبتنی بر ساختار» از این منظر کارایی بیشتری دارند و در سال 2023 نیز شاهد پیشرفت قابل توجهی در الگوریتمهای طراحی این پروتئینها بودیم. برخی از پیچیدهترین این رویکردها، از مدلهای «انتشار» استفاده میکنند که زیربنای ابزارهای تصویرسازی مثل دالئی (DALL-E) نیز هستند. این الگوریتمها در ابتدا برای حذف نویز رایانهای از شمار زیادی از ساختارهای واقعی طراحی شده بودند؛ اما با یادگیری شیوۀ تمایزگذاری میان عناصر ساختارهای واقعی و نویز، قادر شدهاند ساختارهای تعریفشدهای را تشکیل دهند که از نظر زیستشناختی امکانپذیر هستند.

نرمافزار آرافدیفیوژن3 (RFdiffusion3) که توسط آزمایشگاه بیکر و ابزار کروما (Chroma) که توسط شرکت جنریت بیومدسینز (Generate Biomedicnes) در سامرویل، ماساچوست توسعه یافته است، از این استراتژی به خوبی بهرهبرداری کردهاند. مثلاً، تیم بیکر از آرافدیفیوژن3 برای مهندسی پروتئینهای جدیدی استفاده میکند که میتوانند رابطۀ محکمی با اهداف از پیشتعیینشده برقرار کنند. نسخۀ جدیدتر آرافدیفیوژن که با نام «همۀ اتمها» شناخته میشود، به طراحان اجازه میدهد تا به صورت رایانشی پروتئینها را حول اهداف غیرپروتئینی نیز شکل دهند، مثلاً حول دیاناِیها، مولکولهای کوچک و حتی یونهای فلزات. این حد از انعطافپذیری افقهای تازهای پیش روی مهندسی آنزیمها، مواد زیستی کاربردی و دیگر فعالیتها قرار میدهد.

شناسایی جعل عمیق

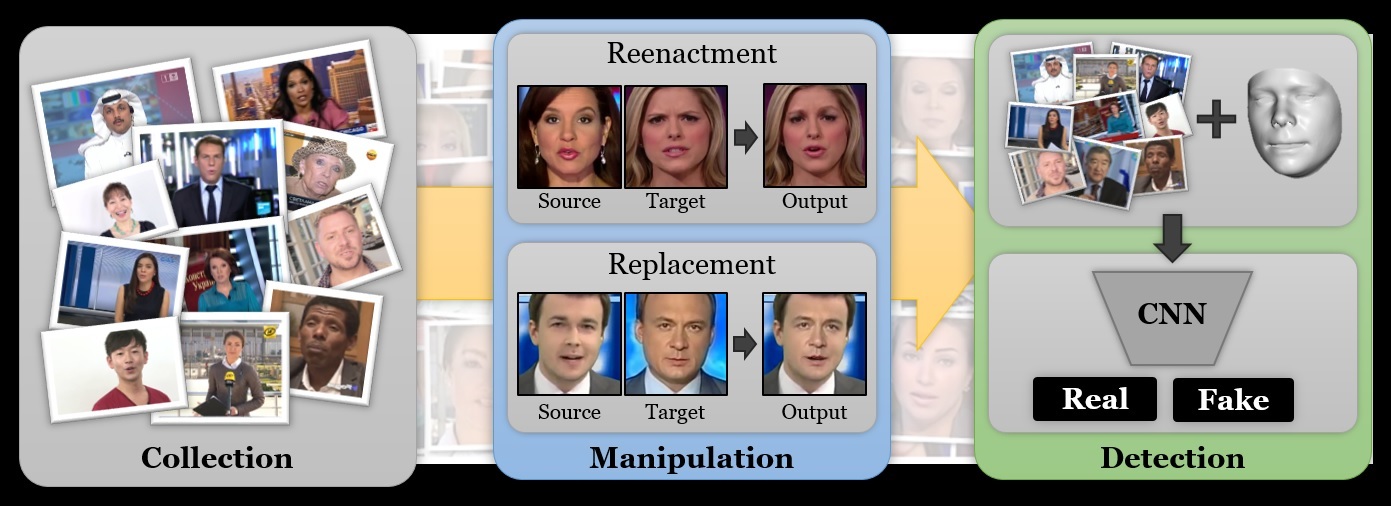

دسترسی عمومی و گسترده به «الگوریتمهای هوش مصنوعی مولد» باعث شده که ترکیب کردن تصویر، صدا و ویدیوهایی که به نظر واقعی میرسند، اما کاملاً ساختگی هستند، بسیار ساده شود. نتیجۀ این امر میتواند ویدئوهای سرگرمکننده باشد؛ اما در میانۀ بحرانهای ژئوپلیتیکی و انتخابات ریاستجمهوری ایالات متحده، این ابزار میتواند به سلاحی رسانهای نیز تبدیل شود.

سیوی لیو (Siwei Lyu)، دانشمند علوم کامپیوتر در دانشگاه بوفالو در نیویورک، میگوید که «مثلاً، تصاویر و صداهایی از درگیریهای میان اسرائیل و حماس را دیده است که توسط هوش مصنوعی تولید شدهاند و «جعل عمیق» هستند.» این مرحلۀ جدیدی از بازی موش و گربه است که طی آن کاربران هوش مصنوعی محتوای فریبنده و ساختگی تولید میکنند و لیو و سایر متخصصان درستیسنجی رسانهها، برای شناسایی و رهگیری محتوای جعلی تلاش میکنند.

یک راه حل این است که توسعهدهندگان هوش مصنوعی سیگنالهای مخفیانهای در خروجی ابزارهای خود جاسازی کنند و بر محتوای تولید شده توسط هوش مصنوعی نشانههایی بگذارند. استراتژیهای دیگری هم هستند که بر خود محتوا تمرکز میکنند. مثلاً در برخی ویدیوهای دستکاری شده، ویژگیهای چهره یک شخصیت عمومی با ویژگیهای چهرۀ شخصیتی دیگر جایگزین میشود و الگوریتمهای جدید میتوانند مرز میان این دو تصویر را شناسایی کنند. یک نمونه این است که چین و چروکهای گوش هر فرد میتواند شاهدی برای عدم تطابق بین صورت و سر باشد، یا بینظمی در ترتیب دندانها یا دقت همگامسازی لبها در ویدیوهای ویرایششده میتواند نشان دهد که آیا در این ویدئو دهان فرد به صورت دیجیتالی دستکاری شده است که حرفی در دهانش گذاشته شود یا نه.

عکسهایی که هوش مصنوعی تولید میکند نیز چالشبرانگیز هستند. در سال 2019، لویزا وردولیوا (Luisa Verdoliva)، متخصص رسانه در دانشگاه فدریکوی دوم ناپل ایتالیا، نرمافزار فیسفورنزیکس++ (FaceForensics++) را توسعه داد. این ابزار میتواند تعیین کند که آیا نرمافزارهای پرکاربرد برای تغییر چهره در عکس استفاده شدهاند یا نه. اما روشهای تشخیص صحت تصویر بسته به هر موضوع و هر نرمافزار متفاوت هستند و تعمیم استفاده از آنها چالشبرانگیز است. لویزا میگوید: «شما نمیتوانید یک آشکارساز جهانشمول داشته باشید؛ چنین کاری بسیار دشوار است.»

علاوه بر همۀ اینها، شیوۀ استفاده از این ابزارها نیز چالشبرانگیز بوده است. برنامۀ سِمافور (SemaFor) با حمایت آژانس پروژههای تحقیقاتی پیشرفتۀ دفاعی ایالات متحده، جعبه ابزار مفیدی برای تجزیه و تحلیل جعل عمیق فراهم کرده است. اما معمولاً رسانههای اجتماعی بزرگ از این ابزار استفاده نمیکنند. گسترش دسترسی به چنین ابزارهایی میتواند منجر به پذیرش آن در رسانههای اجتماعی شود. به همین منظور، تیم لیو پروژهای با نام دیپفیکومتر7 (DeepFake-O-Meter7) راهاندازی کردهاند که یک منبع عمومی متمرکز از الگوریتمهایی است که میتواند محتوای ویدیویی را از زوایای مختلف تجزیه و تحلیل و محتوای جعل عمیق را شناسایی کند. چنین منابعی مفید خواهند بود، اما این احتمال وجود دارد که نبرد علیه اطلاعات نادرستی که هوش مصنوعی تولید میکند برای سالهای سال ادامه پیدا کند.

چتجیپیتی؟ شاید سال بعد

شاید متوجه شده باشید که مضمون مشترک فناوریهای امسال «روشهای یادگیری عمیق» است. اما یکی از ابزارهای بسیار معروف در این حوزه به فهرست نهایی راه نیافته است: رباتهای گفتگوی بسیار پرطرفدار با هوش مصنوعی. به نظر میرسد چتجیپیتی و نمونههای مشابه آن ابزار دست و همکار روزمرۀ بسیاری از محققان شدهاند و حتی توانستهاند به فهرست ده فناوری برتر نیچر برای سال 2023 نیز راه پیدا کنند. پاسخدهندگان یکی از نظرسنجیهای نیچر در ماه سپتامبر چتجیپیتی را به عنوان مفیدترین ابزار مبتنی بر هوش مصنوعی برشمردند و توانایی آن در کدنویسی، نگارش پیشینۀ ادبیات و انجام وظایف اداری را ستودند.

چنین ابزارهایی از منظر عدالت اجتماعی نیز ابزارهای ارزشمندی محسوب میشوند، زیرا به کسانی که انگلیسی زبان اولشان نیست کمک میکنند نثرشان را اصلاح کنند و در نتیجه مسیرشان را برای انتشار و رشد شغلی آسانتر میکند. با این حال، بسیاری از این کاربردها فرآیند تحقیق را دگرگون نمیکند و صرفاً در زحمت لازم و نیروی کار صرفهجویی میکند. علاوه بر این، انتشار مداوم پاسخهای گمراهکننده یا ساختگی در چتجیپیتی نگرانی بیش از دو سوم پاسخدهندگان این نظرسنجی بود. هرچند این ابزار ارزش آن را دارد که در سال آینده از آن بیخبر نمانیم، اما برای رسیدن به بلوغ و تثبیت نقش گستردهتر خود در دنیای علمی نیاز به زمان بیشتری دارند.

انتهای پیام/