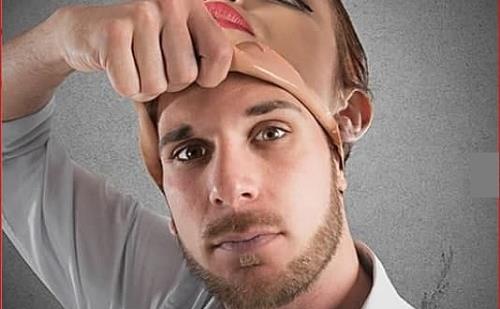

آیا میتوان فیلمهای جعل عمیق را تشخیص داد؟/ وقتی فناوریهای هوشمند به مصاف هم میروند

به گزارش خبرنگار حوزه علم، فناوری و دانشبنيان گروه فناوری خبرگزاری آنا، یکی از تبعات فناوری که هنوز به طور کامل وجه ترسناک خود را نشان نداده است، فناوری جعل عمیق نام دارد. در فناوری «جعل عمیق» (deep fake) فیلمهایی جعلی از افراد ساخته میشود که امکان سوءاستفاده را برای تبهکاران به وجود میآورد.

بیشتر بخوانید:

انحراف علم به دست سودجویان/ هوش مصنوعی چگونه موجب حملات سایبری میشود؟

به طور قطع نمیتوان جلوی پیشرفت فناوری را گرفت. اما آیا در تماشای یک ویدئوی جعل عمیق(deep fake)، میتوان نسبت به ساختگی بودن محتوای ویدئو آگاه شد؟ همزمان با پیشرفت فناوریهای تشخیصی، کیفیت فناوری جعل عمیق نیز افزایش مییابد. اما روشهایی وجود دارد که میتوانید به صورت خودکار و با کمک هوش مصنوعی، جعل عمیق را شناسایی کنید. در این گزارش مروری بر روشهای ساده و همچنین تلاشهای بهکارگیری فناوری ضد خودش خواهیم داشت.

روشهایی برای شناسایی فیلمهای جعل عمیق

به طور کلی راه حل ابتدایی این است که بتوان خود افراد را نسبت به تشخیص ساختگی بودن ویدئوها آگاه ساخت. محققان در حال بررسی بیومتریک نرم(soft biometrics)، از جمله نحوه صحبت فرد و ویژگیهای موجود در فیلم برای کمک به تشخیص جعل عمیق هستند. بدین ترتیب شما میتوانید بهتنهایی این ویژگیها را تشخیص دهید و زمانی که ویدئوی جعل عمیق را روبهرویتان گذاشتند، صحت آن را زیر سوال ببرید. در اینجا به برخی از مهمترین باگهای ویدئوهای جعل عمیق اشاره خواهیم کرد که بدون نیاز به ابزارهای فناوری قابل تشخیص است:

حرکت غیرطبیعی چشم: از طریق حرکات غیرطبیعی چشمان انسان یا کم بودن حرکات چشم، مانند عدم پلک زدن یا تعداد پلکهای غیرطبیعی(هر انسان به طور طبیعی باید بین 15 الی 20 بار در دقیقه پلک بزند) میتوان پی برد که کاسهای زیر نیم کاسه است. بررسی محتواهایی که تاکنون ساخته شده است نشان میدهد برای سازندگان ویدئوهای جعل عمیق، شبیهسازی عمل پلک زدن به روشی طبیعی کار سختی بوده است. همچنین حرکت دادن چشم و نگاه به جاهای مختلف با توجه به اصول پرسپکتیو کار دشواری است.

فقدان احساسات: اگر به نظر نمیرسد چهره شخص در حین بیان صحبتهای مختلف اعم از لحن عصبانی، غمگین، شاد و... تغییر میکند و به طور کل فرد احساسی را از خود بروز نمیدهد آنگاه باید نسبت به اصالت ویدئو شک کرد.

ناهماهنگی سر و بدن: نشانه دیگر این است که اگر فرم بدن فردِ درونِ ویدئو، با حالت چهرهاش هماهنگی نداشته باشد، میتوان نسبت به اصل ویدئو تردید کرد. این ناسازگاری و ناهماهنگی میتواند یکی از راههای آسان تشخیص ویدئویی ساختگی باشد زیرا فناوریهای جعل عمیق معمولاً بیش از کل بدن بر روی ویژگیهای صورت متمرکز هستند(تاکنون که این طور بوده است). بنابراین وقتی دیدید کسی هنگام چرخش به پهلو یا حرکت دادن سر خود، میان حرکت سر و پیکرش توازن برقرار نیست، آنگاه باید به جعلی بودن ویدئو شک کنید.

رنگ و نور: رنگ پوست غیرطبیعی و متفاوت با پوست تن و بدن، سایههای نامناسب و نامتقارن همه از نشانههای جعلی بودن ویدئو است.

موی سر: معمولاً موی افراد در ویدئوهای جعل عمیق کاملاً فریز شده است. بنابراین اگر در ویدئو مشاهده میکنید که موی سر بقیه افراد حاضر در ویدئو در برابر باد تکان میخورد به جز یک نفر، نسبت به جعلی بودن ویدئو تردید کنید.

تاری یا عدم تطابق: اگر لبههای تصاویر تار و مبهم است برای مثال، جایی که صورت و گردن به هم وصل میشوند یک حالت سایهدار غیرعادی وجود دارد باید فرض را بر این گذاشت که کارهایی روی ویدئو صورت گرفته است.

نویز یا صدای متناقض: سازندگان جعل عمیق معمولاً زمان بیشتری را صرف تصاویر ویدئویی میکنند تا صدا. در نتیجه به طور معمول همگامسازی حرکت لب و صدا دقیق نیست و تلفظ عجیب واژهها محسوس است. همچنین به دلیل عدم تسلط سازندگان ویدئوهای جعل عمیق بر تکنیکهای صوتی، به طور معمول سروصدای پس زمینه مصنوعی است یا حتی به طور کل صدایی وجود ندارد.

اختلاف هشتگ: یک نوع الگوریتم رمزنگاری ساده وجود دارد که به سازندگان ویدئو کمک میکند تا نشان دهند که فیلمهای آنها معتبر است یا خیر. معمولاً از الگوریتم درج هشتگ در مکانهای خاص در سرتاسر ویدئو استفاده میشود. اگر هشتگها تغییر کند، پس باید شک داشته باشید که ویدئو دستکاری شده است.

اثر انگشت دیجیتال: یک راه حل صحت فیلمهای ویدئویی درج نوعی مارک پاکنشدنی یا کد تغییرناپذیر است که اگر آن تغییر کند، به طور قطع نشان میدهد یک ویدئو دستکاری شده است. فناوری بلاکچین میتواند این کار را انجام دهد. فناوری بلاکچین همچنین میتواند اثر انگشت دیجیتالی برای فیلمها ایجاد کند. این تأیید مبتنی بر بلاکچین اگرچه بیعیب و نقص نیست، اما میتواند به صحت یک ویدئو کمک کند. اگر همین فناوری در ویدئو اعمال شود چه؟ نحوه کار در اینجا به این صورت است که هنگام ایجاد ویدئو محتوا در نوعی دفتر همزمان ثبت میشود(جایی که محتوا قابل تغییر نباشد). آنگاه این فناوری میتواند به اثبات اصالت یک ویدئو کمک کند.

استفاده از فناوری برای ردیابی ویدئوهای جعل عمیق

تشخیص ویدئوهای هوش مصنوعی تنها با چشم دشوار است و انتظار میرود در سالهای آتی ویدئوهای جعل عمیق واقعیتری ساخته شود، بنابراین فناوریهای در حال توسعه میتواند در این مسیر کمک کند. گروههای مختلفی در حال ارائه روشهایی برای افزایش شفافیت هوش مصنوعی و محافظت از مردم در برابر ویدئوهای جعل عمیق هستند. در ادامه تعدادی از شرکتها و سازمانهایی را که برای مبارزه با ویدئوهای جعلی تلاش میکنند، معرفی خواهیم کرد:

توئیتر و فیسبوک: این دو شبکه مجازی بزرگ استفاده از جعل عمیق مخرب را ممنوع کردهاند و در صورت گزارش افراد، آن را از صفحات خود پاک میکنند.

گوگل: شرکت گوگل با توجه به اینکه روزبهروز ویدئوهای جعل عمیق دقیقتر میشوند برای تأیید صدای ویدئوها روی ابزاری برای تبدیل متن به گفتار ویژه کار میکند.

ادوب(Adobe): این شرکت سیستمی را برپا کرده است که به شما امکان میدهد نوعی امضای دیجیتالی را به محتوای خود اضافه کنید. Adobe همچنین در حال توسعه ابزاری برای تعیین این است که آیا تصویر دستکاری شده یا خیر.

آزمایشگاه دانشگاه کالیفرنیای جنوبی: محققان این دانشگاه و چند دانشگاه دیگر در تلاشاند با استفاده از فناوری یادگیری ماشینی، روشهای بیومتریک نرم مانند اختلاف بین اجزای صورت و نحوه ادای واژگان را بررسی کنند. ابزار تولیدی آنها تاکنون با دقت 92 تا 96 درصد توانسته است جعل عمیق را تشخیص دهد.

بیشتر بخوانید:

جدال انسان و ماشین بر سر شغل/ وقتی هوش مصنوعی نیروی انسانی را آموزش میدهد

آژانس پروژههای تحقیقاتی پیشرفته دفاعی آمریکا DARPA: وزارت دفاع آمریکا، بودجهای تحقیقاتی را برای توسعه ابزار خودکار برای تشخیص ویدئوهای جعل عمیق اختصاص داده است تا از طریق برنامهای به نام MediFor یا Media Forensics ویدئوهای ساختگی از ویدئوهای معمول را تفکیک کند.

انتهای پیام/4144/پ

انتهای پیام/